Von der Idee zur Umsetzung: KI-Modelle mit Vertex AI in der Google Cloud

Der Weg von der ersten Idee bis zur Umsetzung einer KI-Anwendung ist oft komplex. Moderne Cloud-Technologien bieten jedoch leistungsstarke Lösungen, um diesen Prozess zu vereinfachen. Mit effizienten Tools lassen sich Modelle gezielt entwickeln, testen und in Arbeitsabläufe integrieren. Vertex AI in der Google Cloud ermöglicht dabei die nahtlose Verknüpfung von interaktiven Notebooks mit KI-Pipelines, um Workflows effizient zu gestalten.

Die smarte KI-Begleitung für alle Fälle

Vertex AI ist eine Plattform für maschinelles Lernen in der Google Cloud Platform (GCP) und ermöglicht die Entwicklung von Künstlichen Intelligenzen (KI) und KI-gestützten Anwendungen. Es bietet außerdem eine Reihe von Basismodellen an, welche nach Belieben trainiert und mittels Jupyter Notebooks verwaltet werden können. Diese Notebooks sind mit einigen gängigen Machine-Learning-Modulen vorkonfiguriert und ermöglichen daher eine unkomplizierte Nutzung. Dadurch soll eine komplexe Konfiguration vermieden, Lizenzkosten für Drittanbieter-Software, wie zum Beispiel Anaconda, gespart und stets eine aktuelle Umgebung gewährleistet werden.

Um die Vorteile einer Cloud-Infrastruktur gänzlich auszunutzen, kann der Auf- und Abbau einer Vertex AI-Instanz mit Terraform automatisiert werden. Die benötigte Infrastruktur wird als deklarativer Code implementiert, weiterentwickelt und kann anschließend per Knopfdruck eingerichtet werden. Die JSON-ähnliche Code-Struktur macht die Cloud-Infrastruktur verständlich und unkompliziert.

War das etwas schon alles?

Trainierbare KI-Basismodelle und Jupyter Notebooks sind aber nicht das Einzige, was Vertex AI zu bieten hat.

Integrierte Datenplattform

Ein besonders hervorzuhebendes Feature ist die nahtlose Integration mit Dataproc, Googles Hadoop-Distribution. Dies ermöglicht die Nutzung von Technologien wie Apache Spark, Kafka und Hive direkt auf der Plattform. Dadurch können komplexe Machine-Learning-Aufgaben auf verteilten Systemen ausgeführt und anspruchsvollere Anwendungsfälle implementiert werden.

Tools für eine mächtige ML-Ops-Plattform

Darüber hinaus bietet der Vertex AI-Modellgarten eine breite Palette an vortrainierten Modellen, die als Ausgangspunkt für eigene Entwicklungen genutzt werden können. Diese Modelle können problemlos in Jupyter Notebooks integriert und weitertrainiert werden, was den Nutzer:innen erlaubt, sich auf die Feinabstimmung ihrer Modelle zu konzentrieren, anstatt von Null zu beginnen. Zusätzlich ermöglicht Vertex AI die einfache Einbindung von CI/CD-Pipelines, um Maßnahmen zur Qualitätssicherung, wie funktionale und fachliche Tests oder Prüfungen nach offenen Sicherheitslücken, automatisiert auszuführen. So können neue Modelle und Anwendungen schneller entwickelt und bereitgestellt werden.

Flexibles Ressourcenmanagement

Mit Vertex AI können geschriebene Notebooks in AI-Pipelines eingebunden werden, um bestimmte Teil-Aufgaben zu realisieren. Um die Laufzeit dieser Aufgaben zu reduzieren, bietet die GCP eine Reihe an sogenannten Beschleunigern, um die Leistung der verwendeten Hardware aufzuwerten. Diese Beschleuniger basieren entweder auf einem Grafik- oder Tensor-Prozessor und sind für komplexe Berechnungen bzw. für TensorFlow-Modelle optimiert. Die automatische Skalierung der Infrastruktur durch Vertex AI sorgt zudem dafür, dass Ressourcen nur dann genutzt werden, wenn sie wirklich benötigt werden. Dies reduziert nicht nur die Kosten, sondern sorgt auch für eine effizientere Nutzung der verfügbaren Rechenleistung.

Managed Notebooks

Ein weiterer großer Vorteil von Vertex AI ist die Bereitstellung von Managed Notebooks. Diese Notebooks bieten eine vollständig verwaltete Umgebung, die speziell für maschinelles Lernen optimiert ist. Sie eliminieren den Aufwand für manuelle Konfiguration und Wartung, welche bei herkömmlichen Jupyter Notebooks oft zu einem hohen Zeit- und Ressourcenaufwand führen. Dadurch verliert der Quellcode zum Bereitstellen der Infrastruktur einen großen Teil an Komplexität, sorgt für eine Reduktion von technischen Fehlern und macht die Plattform wartbarer.

Und was kostet der Spaß?

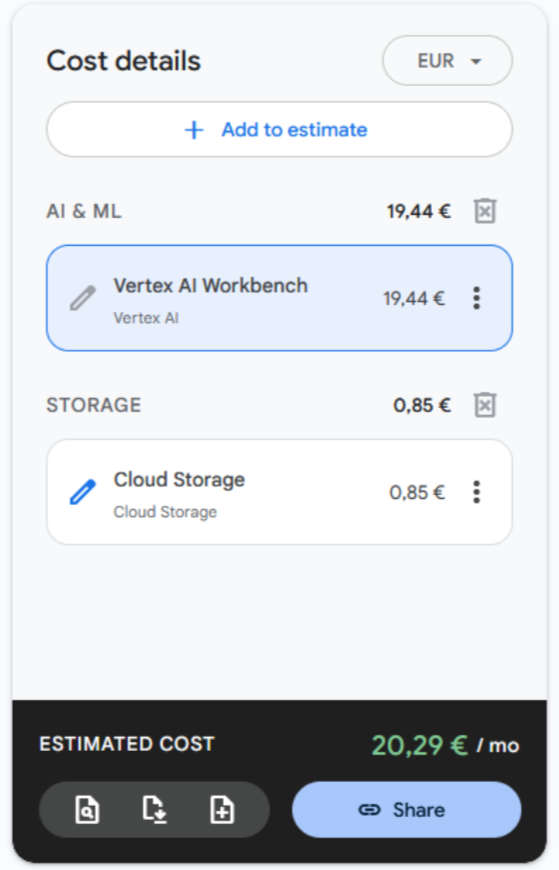

Die Kosten für eine Vertex AI-Instanz setzen sich aus Betriebskosten einer Compute Engine, einem Storage Bucket und der Verwaltungsgebühr der Notebook-Instanzen zusammen.

Die Verwaltungsgebühren der Notebooks beläuft sich auf ungefähr 0,05€ pro virtueller CPU pro Stunde und weiteren 0,007 € für jeden Gigabyte Arbeitsspeicher. Auch die Größe des Bootlaufwerks der einzelnen Instanzen beeinflusst die Verwaltungskosten. Bei der Nutzung eines Standardlaufwerks fallen im Monat ungefähr 0,05 € pro Gigabyte an. Die Nutzung eines Beschleunigers würde sich ebenfalls auf die Servicekosten auswirken. Die Gebühren steigen dann abhängig von der verwendeten Grafikkarte.

Eine minimalistische Vertex AI Instanz hätte wöchentliche Kosten in Höhe von rund 20 €, wenn man davon ausgeht, dass die Plattform dauerhaft betrieben wird.

Fazit

Der Einsatz von Vertex AI in der Google Cloud ermöglicht eine moderne, effiziente und skalierbare Machine Learning-Infrastruktur, die den Herausforderungen klassischer, selbstverwalteter Umgebungen überlegen ist. Durch die Integration von Managed Notebooks, leistungsstarken ML-Ops-Tools und Funktionen für flexibles Ressourcenmanagement können Unternehmen und Forschungsprojekte gleichermaßen profitieren. Die Automatisierung durch Terraform erleichtert zudem die Bereitstellung und Wartung der Infrastruktur erheblich.

Neben den technischen Vorteilen sorgt Vertex AI auch für eine Kostentransparenz und optimierte Ressourcennutzung, was insbesondere für zeitlich begrenzte oder skalierbare ML-Projekte von Vorteil ist. Die Kombination aus nahtloser Integration mit bestehenden Google Cloud-Services, der Verfügbarkeit vortrainierter Modelle und der Möglichkeit, leistungsfähige ML-Pipelines zu erstellen, macht Vertex AI zu einer attraktiven Lösung für Unternehmen, die die eigene KI-Entwicklung beschleunigen und effizient gestalten möchten.

Seminarempfehlungen

TERRAFORM ESSENTIALS TERRA-01

Mehr erfahrenMACHINE LEARNING BASICS DB-AI-01

Mehr erfahrenCLOUD COMPUTING ESSENTIALS CLOUD-COMP

Mehr erfahrenPYTHON PROGRAMMIERUNG GRUNDLAGEN P-PYTH-01

Mehr erfahrenPYTHON PROGRAMMIERUNG FÜR FORTGESCHRITTENE P-PYTH-02

Mehr erfahrenJunior Consultant bei ORDIX

Kommentare