ETL-Tools in der Cloud

In unserem Marktüberblick über ETL-Tools in der Cloud haben wir uns mit der Frage beschäftigt, welche Möglichkeiten es gibt, ein zentrales Data Warehouse in der Cloud aufzubauen. Heutzutage bieten alle großen Software-Hersteller BI-Tools in der Cloud an, die auch den Zugriff auf on-prem Daten ermöglichen. Doch welche Optionen stehen zur Verfügung, um das volle Potenzial der Cloud für das Data Warehouse auszuschöpfen?

SaaS statt IaaS

Was schon jahrelang möglich war und heutzutage immer noch sehr häufig eingesetzt wird, ist die Möglichkeit bewährte ETL-Tools, wie Talend, Datastage, OWB/ODI, etc. auf einem dedizierten Server in der Cloud zu betreiben. Dieses Vorgehen folgt dem Konzept von Infrastructure as a Service. Es wird ein Server in der Cloud aufgesetzt und dort die ETL-Software installiert. Grundsätzlich ist dieses Vorgehen von on-prem ETL sehr ähnlich, da die Software sich gleich verhält und die Administration des Servers übernommen werden muss. Sicherlich müssen ein paar ETL-Strecken freigeschaltet werden, allerdings ist dieses in Unternehmensnetzwerken on-prem auch oft nötig.

Will man einen Schritt weiter gehen, setzt man auf Software as a Service und verzichtet auf die Administration eines Servers und die damit verbundenen Aufwände.

Mittlerweile haben alle großen Cloud-Provider solche Tools in Ihrem Werkzeugkasten, aber auch unabhängige Anbieter versuchen sich auf dem Markt zu positionieren.

Tools wie Sand am Meer

Wenn man sich mit dem Thema der Tool-Auswahl beschäftigt, stellt man sehr schnell fest, dass es mittlerweile unzählige Lösungen auf dem Markt gibt.

So gibt es unter anderem die folgenden Tools der großen Cloud-Anbieter:

- AWS Glue

- Google Cloud Data Fusion

- Microsoft Azure Data Factory

- Informatica Cloud Data Integration

- OCI Data Integration

Aber auch viele kleinere „Exoten“ sind auf dem Markt vertreten, so z. B.:

- Denodo

- Domo

- Etlworks

- Hevo

Kennt man eins, kennt man alle!?

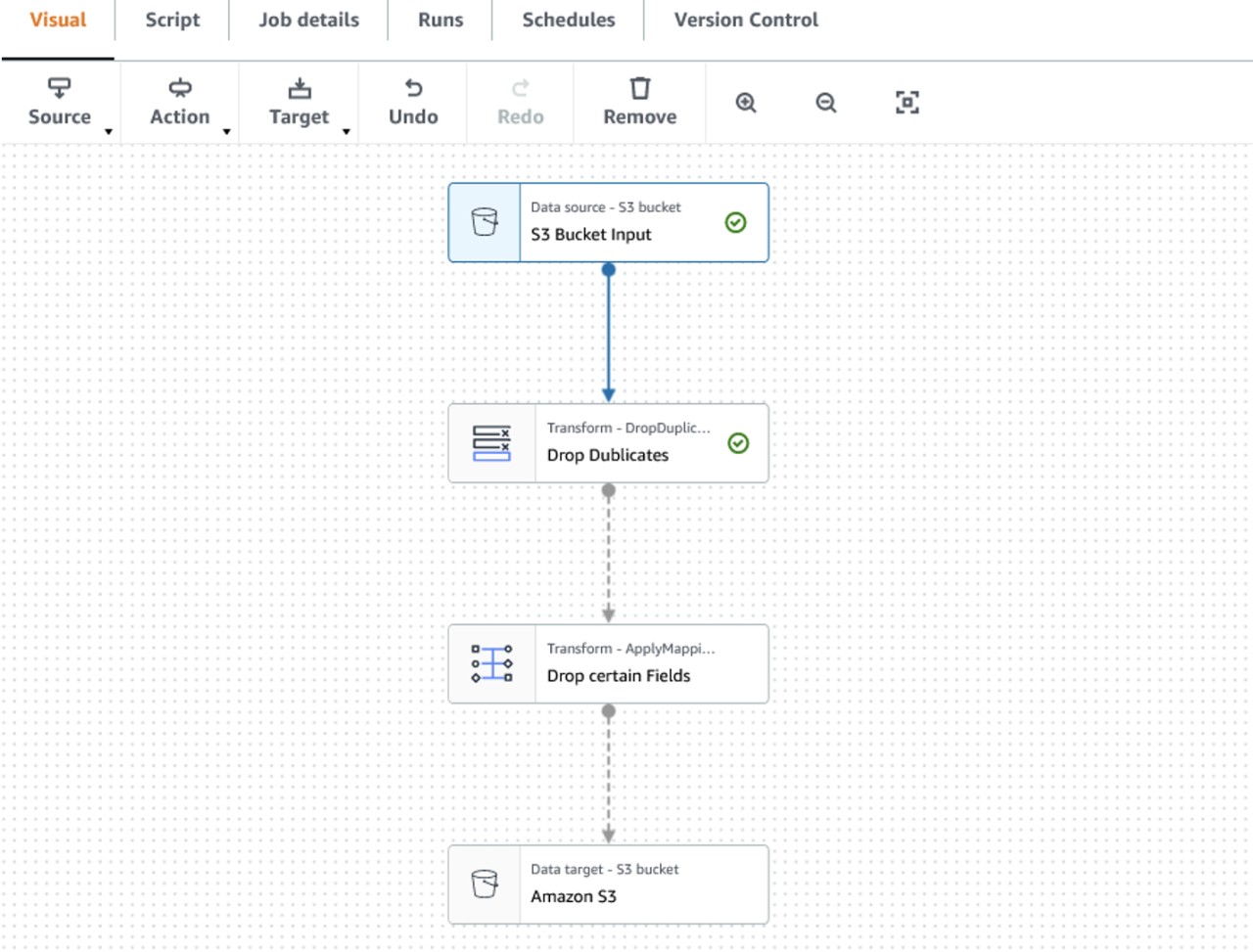

Was die Bedienung der verschiedenen Tools betrifft, so sind sie doch sehr ähnlich aufgebaut und funktionieren grundsätzlich nach gleichem Prinzip:

1. Definition der Speicherorte für Input und Output

2. Erstellen eines „Flows“, der Daten aus den Quellen zieht, transformiert und in die verschiedenen Ziele schreibt.

3. Ausführen der „Flows“

Zwar unterscheiden sich die Tools bei der Benennung der einzelnen Komponenten sowie ETL-Strecken, bei der Erstellung ebendieser zeigen sie in der GUI aber einen deutlichen Wiedererkennungswert, den man auch von on-prem Tools kennt.

Größere Unterschiede gibt es dann beim Ausführen der Flows. So erlauben manche Tools das direkte Ausführen und Debuggen, bei anderen Tools wiederum muss die ETL-Strecke erst deployt werden und kann dann nicht mehr verändert werden.

Was kostet das Ganze?

Die zwei wichtigsten Fragen, die sich jeder stellt: Welches ist das richtige Tool und was kostetet es am Ende? Wobei die Frage nach den Kosten die Tool-Auswahl zusätzlich beeinflusst.

Und hier unterscheiden sich die Tools doch deutlich voneinander, was die Kostenberechnung betrifft. So fallen bei einigen Tools, wie z. B.: AWS Glue erst Kosten an, wenn Flows ausgeführt werden. Bei anderen Tools, wie z. B.: Google Cloud Data Fusion, sobald Flows erstellt werden und zur Verfügung stehen, egal ob sie ausgeführt werden oder nicht.

Metriken, die sich aber immer wieder bei der Berechnung wiederfinden, sind die Anzahl der CPUs, der Speicherplatz sowie das Datenvolumen, das transferiert wird.

Im Gegensatz zu den kleineren Anbietern, bei denen man mit dem Vertrieb über Kosten sprechen muss, bieten die großen Anbieter Kostenkalkulatoren an.

Die Kostenkalkulatoren der Anbieter ermöglichen die Berechnung der entstehenden Kosten basierend auf den eingegebenen Parametern. Allerdings ist aus unserer Sicht die Bestimmung dieser Parameter keine einfache Aufgabe und eine valide Einschätzung kann nur durch einen Proof-of-Concept erfolgen. Vorher ist es schwierig abzuschätzen, wie viele CPUs für eine effiziente Umsetzung der Flows benötigt werden und wie viel Daten bei den Transformationen generiert werden.

Ein entscheidender Faktor, der die Tool-Auswahl maßgeblich beeinflusst, ist der bereits genutzte Cloud-Anbieter. In den seltensten Fällen startet man mit dem ETL-Prozess als ersten Schritt in der Cloud. Oftmals hat man bereits Datenquellen und/oder BI-Systeme in der Cloud, wodurch man sich bereits an einen bestimmten Anbieter gebunden hat. Daher ist es wichtig, dass das gewählte ETL-Tool gut mit dem vorhandenen Cloud-Anbieter harmoniert. Ist man z. B. mit Datenquellen und BI-Systemen in der AWS-Cloud, macht es normalerweise keinen Sinn, das ETL-Tool bei einem anderen Anbieter aufzusetzen.

Bei Multi-Cloud-Systemen wird das Ganze dann wieder interessanter, da man hier Tools der verschiedenen Anbieter wieder in Betracht ziehen kann.

An einem POC (mit ORDIX) führt kein Weg vorbei

Wie im oberen Absatz schon zu lesen war, führt aus unserer Sicht kein Weg an einem Proof-of-Concept vorbei. Genau dieses Vorgehen setzen wir bei ORDIX bei unseren ETL- und BI-Projekten um (mehr dazu im nächsten Blog-Beitrag zum Thema BI bei ORDIX). Sollten Sie vor einer Herausforderung stehen oder gerne mehr zu einzelnen ETL-Tools in der Cloud erfahren wollen, zögern Sie nicht, uns zu kontaktieren. Unsere ETL- und BI-Experten unterstützen und beraten Sie gerne.

Seminarempfehlungen

DATA WAREHOUSE GRUNDLAGEN DB-DB-03

ZUM SEMINARAPACHE NIFI GRUNDLAGEN DB-BIG-07

ZUM SEMINARTALEND - EINE EINFÜHRUNG IN DAS GRAFISCHE ETL-TOOL - KOSTENLOSES WEBINAR W-TALEND-1

ZUM SEMINARAPACHE NIFI GRUNDLAGEN - KOSTENLOSES WEBINAR W-NIFI-01

ZUM SEMINARPrincipal Consultant bei ORDIX

Kommentare